Analytics

Self Service Analytics for Data Lakehouse

Create value from data

Performa serta kualitas dan kontrol data yang lebih baik memberi Anda kemampuan untuk menciptakan lebih banyak nilai dari data.

Simplify your data landscape

Menyediakan satu sumber untuk semua data dan menghilangkan kebutuhan akan sistem terpisah untuk melayani aplikasi data waktu nyata.

Protect and secure your data

Keamanan menyeluruh serta manajemen dan tata kelola data tingkat lanjut menambah keandalan dan kualitas data lake Anda.

Scalable Analytics Platform

Data mesin sering kali merupakan salah satu aset yang paling kurang dimanfaatkan dalam sebuah bisnis, meskipun merupakan salah satu bidang analisis dengan pertumbuhan tercepat dan dianggap penting. Untuk mencapai transformasi digital, data mesin harus memberikan wawasan real-time dan nilai komersial. Namun, penggunaan data ini menimbulkan kesulitan yang signifikan. Kekuatan Platform Analisis yang Dapat Diskalakan dalam kemampuannya membuka kunci data di seluruh bagian bisnis. Data mungkin berasal dari berbagai sumber, termasuk aplikasi, perangkat, jaringan, sensor Internet of Things (IoT), dan lalu lintas web. Dengan Splunk, organisasi dapat mengumpulkan data, mengajukan pertanyaan, memperoleh jawaban, mengambil tindakan, dan mencapai tujuan bisnis. Wawasan yang dihasilkan dapat membantu mereka mengidentifikasi ancaman keamanan, mengoptimalkan kinerja aplikasi, dan memahami perilaku pelanggan.

Predictive Analytic

Organisasi saat ini harus menghadapi data yang dihasilkan lebih cepat dari sebelumnya. Ekspansi Industrial Internet of Things (IIoT) telah mempercepat jumlah sumber, yang menambah torrent data (sensor, aktuator, dan perangkat lainnya). Informasi dari sumber tersebut sering kali berkaitan dengan status fungsional atau operasional sistem atau mesin IIoT yang terhubung.

Data mesin dalam jumlah besar tidak selalu menghasilkan wawasan dalam jumlah besar. Salah satu alasan utama sulitnya melakukan studi yang menghasilkan wawasan yang dapat ditindaklanjuti adalah volume data saat ini, kecepatan pembuatan data baru, dan variasi data yang dibuat. Tim harus berkonsentrasi pada waktu dan alasan pemeliharaan peralatan yang tidak terduga dan tepat waktu yang akan rusak dan menyebabkan waktu henti yang mahal dan tidak terencana.

Kami dapat membantu platform analitik yang membantu organisasi dengan cepat dan dalam skala besar memperoleh visibilitas dan wawasan data untuk mengambil tindakan prediktif yang akan menguntungkan bisnis dan operasi Anda.

Untuk memprediksi kejadian di masa depan, seperti kemungkinan kerusakan peralatan dan mesin, pemeliharaan prediktif adalah pendekatan yang menggunakan analisis data dan algoritma pembelajaran mesin. Pemeliharaan prediktif dapat mengoptimalkan kapan dan bagaimana melakukan pemeliharaan pada aset TI atau mesin industri menggunakan data, analitik, pembelajaran mesin, dan pemodelan.

The Dell Validated Design for Analytics

Kami dapat membantu Pemeliharaan Prediktif dengan menggabungkan data, statistik, pembelajaran mesin (ML), dan pemodelan untuk memberikan wawasan yang dapat ditindaklanjuti kepada bisnis tentang mesin produksi. Hal ini memungkinkan bisnis untuk menghindari melakukan perbaikan yang tidak perlu, secara proaktif mencegah kegagalan mesin yang berpotensi menimbulkan bencana, dan menghilangkan biaya downtime yang tidak direncanakan yang mengurangi keuntungan.

Edge-based Analytics

Penyerapan, pemindahan, pemrosesan, dan penyimpanan data menimbulkan biaya tambahan yang cukup besar untuk setiap proyek dengan potensi laba atas investasi yang signifikan. Dalam fasilitas industri modern, peralatan penyimpanan disk mungkin terisi penuh sebelum dapat dibeli dan dipasang jika data dialirkan dari semua sumber dari setiap peralatan dan sensor. Tapi untuk tujuan apa? Dalam konteks Industri 4.0, membangun data lake yang lengkap tidak mungkin menghasilkan laba atas investasi (ROI) yang menguntungkan.

Penyerapan, pemindahan, pemrosesan, dan penyimpanan data menimbulkan biaya tambahan yang cukup besar untuk setiap proyek dengan potensi laba atas investasi yang signifikan. Dalam fasilitas industri modern, peralatan penyimpanan disk mungkin terisi penuh sebelum dapat dibeli dan dipasang jika data dialirkan dari semua sumber dari setiap peralatan dan sensor. Tapi untuk tujuan apa? Dalam konteks Industri 4.0, membangun data lake yang lengkap tidak mungkin menghasilkan laba atas investasi (ROI) yang menguntungkan.

Dengan pengetahuan ini, kita dapat mendefinisikan kurasi data, yang mungkin merupakan masalah terberat di Industri 4.0. Bagaimana perusahaan dapat memilah lautan data yang tersedia saat ini untuk menemukan aliran data yang akan membantu menghasilkan ROI yang lebih besar? Topik-topik yang potensial mencakup, antara lain, penurunan biaya, penurunan risiko terhadap keselamatan, dan peningkatan produksi. Namun demikian, sebagian besar perusahaan belum menemukan cara yang efektif untuk mentransfer data dari populasi “sesuatu” Internet industri yang sangat besar ke lokasi di mana personel dan peralatan yang sesuai dapat digunakan untuk mengekstraksi wawasan yang berharga.

Dua langkah lagi dalam rantai nilai perlu diterapkan setelah masalah kurasi data teratasi. Teknik dan teknologi apa yang diperlukan untuk membantu ilmuwan data dan pemrogram perangkat lunak membangun sistem cyber-fisik yang cerdas berdasarkan data yang dipilih? Terakhir, bagaimana para perancang dapat menerapkan model dan perangkat lunak mereka di dekat sumber data yang akan memberikan inferensi dan dukungan keputusan? Arsitektur referensi ini memberikan jawaban terhadap permasalahan penting ini dengan memulai dengan anggapan bahwa data dapat diakses dan terjangkau.

Dalam situasi serumit Industri 4.0, tidak ada solusi ajaib. Oleh karena itu, tidak ada satu pun teknologi atau pendekatan yang dapat mengatasi kesulitan dalam merancang, mengembangkan, dan mengimplementasikan sistem siber-fisik untuk setiap jenis permasalahan. Solusi terbaik diciptakan dengan teknologi yang dapat digunakan untuk beberapa kasus penggunaan dan aplikasi.

Metode analisis Industri 4.0 harus secara dinamis memilih dan merutekan data aplikasi yang diperlukan dari sejumlah perangkat. Data ini kemudian harus melewati pemrosesan di hulu, di inti, atau di cloud. Praktisi Industri 4.0 harus mampu mengelola aliran data serta mengalirkan artefak model data ke infrastruktur yang mendukung aplikasi praktis dan pemecahan masalah seperti meningkatkan keandalan peralatan, mengendalikan kesehatan dan keselamatan pekerja, dan meningkatkan hasil panen.

The Dell Technologies Validated Design for Analytics

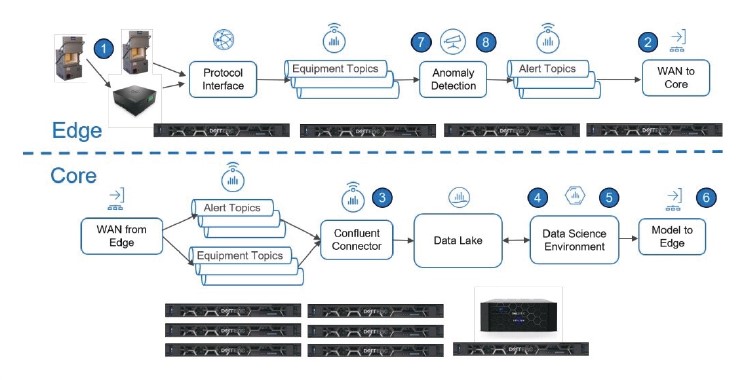

Edge Analytics untuk Industri 4.0 dengan desain Confluent Platform menunjukkan bagaimana Confluent Platform, yang dibangun di atas infrastruktur Dell EMC, dapat digunakan untuk mengatasi tantangan industri IoT dan Industri 4.0, sehingga memberdayakan bisnis untuk menggunakan data guna meningkatkan efisiensi dan pengambilan keputusan.

Real-Time Data Streaming

Untuk mendorong inovasi, meningkatkan kelincahan, dan membantu pengembangan produk dan layanan digital baru, dunia usaha memperbarui arsitektur TI mereka. Ketika bisnis beralih dari pemrosesan batch ke data real-time dan aplikasi berbasis peristiwa, perubahan ini juga menyebabkan perubahan mendasar dalam cara data mendukung bisnis inti perusahaan.

Platform streaming data adalah langkah pertama menuju perusahaan real-time. Platform streaming menggabungkan lapisan penyimpanan dan lapisan pemrosesan dengan kekuatan model publikasi-berlangganan dalam pengiriman data. Hasilnya, menyiapkan jalur data dan menghubungkannya ke semua sistem Anda menjadi lebih sederhana. Dengan mengimplementasikan platform streaming, aplikasi yang membutuhkan data dapat mengaksesnya secara instan tanpa mengalami latensi pemrosesan batch.

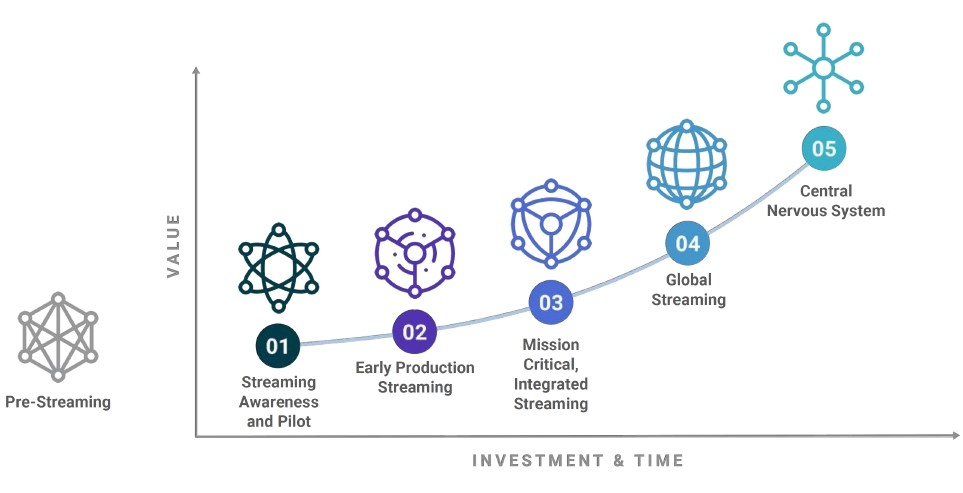

Gambar 1: Perjalanan adopsi streaming menggambarkan perkembangan logis dari adopsi analisis data streaming di sebagian besar lingkungan klien. Keberhasilan, kinerja, dan skalabilitas platform streaming bergantung pada pemilihan infrastruktur yang tepat.

Manfaat yang didapat dari penggunaan Desain Tervalidasi untuk Streaming Data Real-Time adalah:

Aktifkan pipeline data real-time dan aplikasi streaming dengan mengintegrasikan data dari berbagai sumber ke dalam satu platform streaming peristiwa terpusat.

Filter dan aliran data secara efisien ke tempat orang dan alat yang tepat dapat diterapkan untuk mengekstraksi wawasan yang berguna.

Manfaatkan desain tervalidasi yang menyederhanakan penyambungan sumber data ke Apache Kafka, membangun aplikasi dengan layanan Kafka, dan mengamankan, memantau, serta mengelola infrastruktur Kafka.

Large-Scale Streaming Data Processing

Agar perusahaan dapat menggunakan analitik guna meningkatkan keputusan bisnis dan mendukung aplikasi pembelajaran mesin (ML) generasi berikutnya, mereka harus mampu memproses data dalam jumlah besar, baik itu data batch atau streaming.

Sementara itu, ilmu data telah berkembang melampaui kemampuan para spesialis operasi TI, menskalakan sistem yang luas dan tersebar untuk memenuhi kebutuhan para ilmuwan data yang bekerja dengan volume data yang terus meningkat memberikan tantangan baru. Kubernetes berkontribusi secara signifikan pada bidang ini.